Koataemon操作手册

一、安装

系统需求:

- Python版本大于等于3.10

1. 安装Kotaemon

使用Docker安装

Kotaemon支持Docker安装

使用Docker进行安装,需要在命令行中运行命令

docker run \

-e GRADIO_SERVER_NAME=0.0.0.0\ -e GRADIO_SERVER_PORT=7860\

-p 7860:7860 -it --rm\

ghcr.io/cinnamon/kotaemon:main-lite

不使用Docker安装

- 克隆和安装Kotaemon依赖库到创建的虚拟环境中

可以直接通过git拉取代码,也可以直接到github或者gitee上下载.zip压缩包,然后再解压到对应的目录下,两种方式都可以,哪种方便使用哪一种。

# clone this repo

git clone https://github.com/Cinnamon/kotaemon

cd kotaemon

通过Pycharm打开Kotaemon项目,在终端中运行以下命令:

# optional (setup env)

conda create -n kotaemon python=3.10

conda actiavte kotaemon

pip install -e "libs/kotaemon[all]"

pip install -e "libs/ktem"

在所有的依赖都安装成功之后,就可以运行Koaetom了,通过运行app.py启动项目。

python app.py

2. 安装扩展:PDF浏览器 PDF_JS_DIST

https://github.com/mozilla/pdf.js/releases/download/v4.9.155/pdfjs-4.9.155-dist.zip

安装这个扩展主要是用于在网页上查看我们上传的PDF文档。下载完成后的压缩包,解压之后直接放到Kotaemon项目的libs/ktem/ktem/assets/prebuilt目录下即可。

2. 安装Ollama

如果你没有在本地安装任何的机器学习模型,也没有对Kotaemon做任何的配置,那么你是无法正常使用Kotaemon的功能的,还需要对Kotaemon进行配置,具体是修改项目下的.env文件

- 通过OpenAl的api访问模型

OPENAI_API_BASE=https://api.openai.com/v1

OPENAI_API_KEY=openai_key

OPENAI_CHAT_MODEL=gpt-4o

OPENAI_EMBEDDINGS_MODEL=text-embedding-3-small

但这种方法需要魔法,因此作为入门的我们先使用本地的安装的模型

- 通过本地下载大语言模型

首先,需要安装Ollama,Ollama是一个开源的项目,能够非常方便地下载和管理我们的大语言模型,所以我们先需要安装Ollama。Windows系统可以在Ollama的官网上直接下载安装程序进行安装。Ollama默认安装路径为C盘,如果你希望Ollama将模型安装到其他盘,可以在安装好Ollama之后,在系统的环境变量中添加Ollama的环境变量OLLAMA_MODELS=G:\OllamaCache,可以指定你想要的路径。

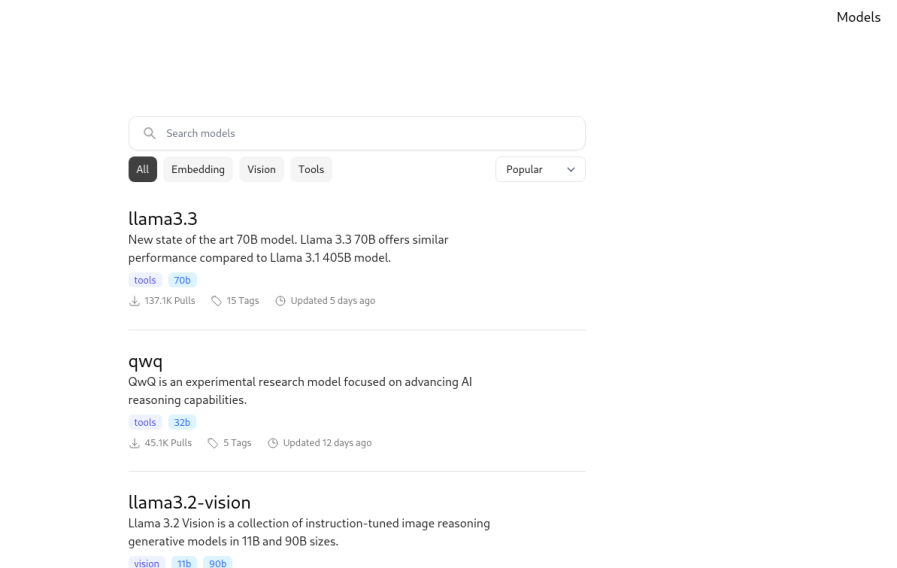

安装好Ollama之后,可以在命令行中输入ollama pull xxx来下载模型。你可以根据电脑的配置来选择下载的模型。如果你不知道有哪些模型可以下载,可以到Ollama的官网上进行查找

这里直接选择Kotaemon默认的模型,在命令行中输入命令

ollama pull llama3.1:8b ollama pull nomic-embed-text

Ollama便会自动下载模型,我们需要等待Ollama下载完成。在下载完成之后,运行命令

ollama run llama3.1

之后,如果进入交互页面,则说明模型启动成功。

3. Koaemon配置本地LLM模型以及Embedding模型

在下载好模型之后,还需要进一步修改配置文件和网页上的配置

.env

# settings for local models

LOCAL_MODEL=llama3.1:8b

LOCAL_MODEL_EMBEDDINGS=nomic-embed-text:latest

网页配置

- 进入Resourses--> LLMs,选择ollama,并填入对应的配置信息

api_key: ollama

base_url: http://localhost:11434/v1

model: llama3.1:8b

填好之后,需要测试是否能够正确连接到模型,点击测试,在确认返回了success之后再点击保存,并勾选上'Set default'设为默认模型。

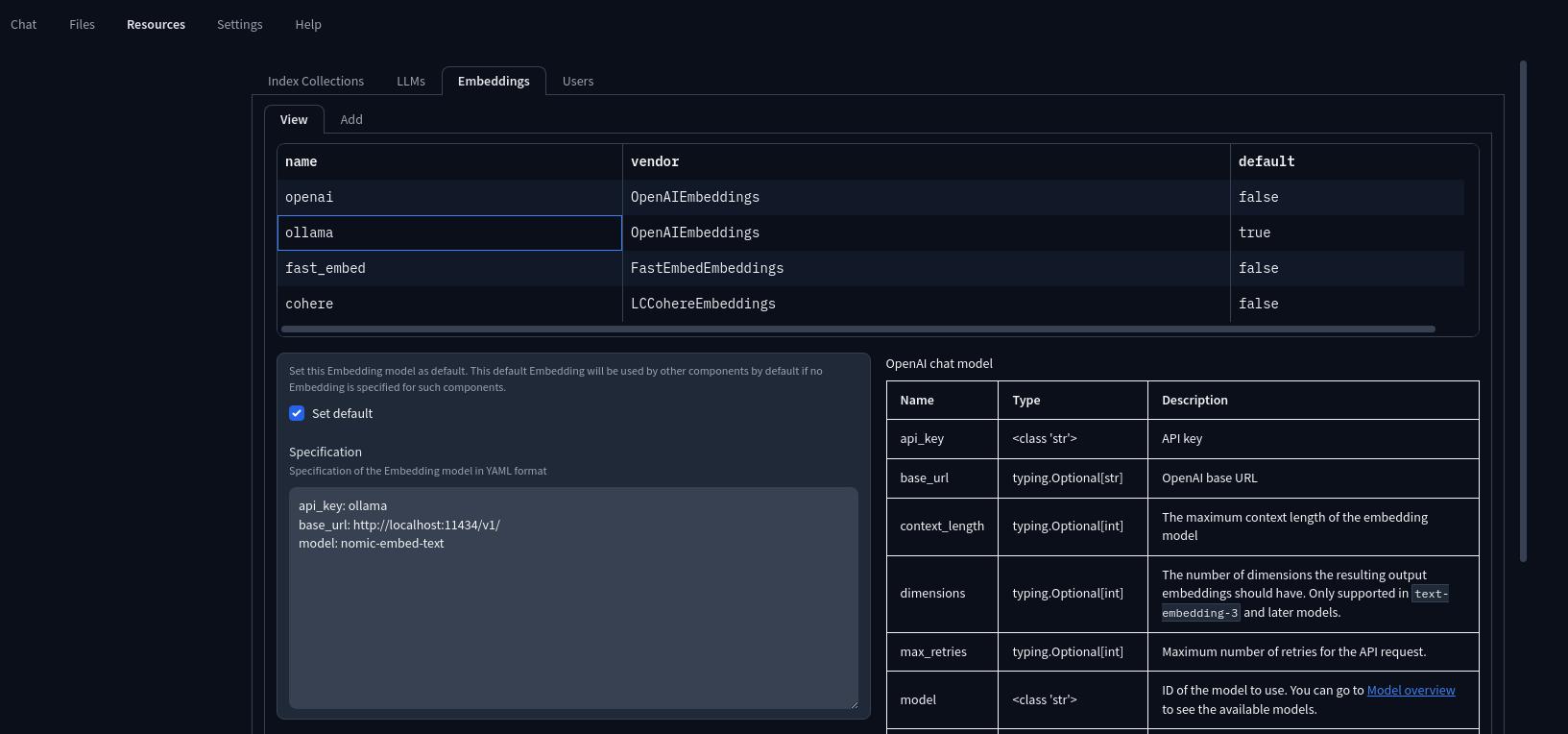

- 然后进入Embeddings,同样选择ollama,填入对应的配置信息

api_key: ollama

base_url: http://localhost:11434/v1

model: nomic-embed-text

同样测试连接成功之后再点击保存,勾选上'Set default'。

保存之后就可以开始使用了

二、使用

1. 运行

在一切就绪之后,运行app.py启动项目,可能会遇到以下一些错误

- 找不到主题文件themes_theme_schema@0.0.1.json

需要修改libs/ktem/ktem/app.py文件,将路径修改为你主题文件所在的位置

with open(r"\kotaemon\themes_theme_schema@0.0.1.json","r") as theme_file: theme_data=json.load(theme_file)

2. 无法通过ip地址访问网页

在lauch中加入server_name="0.0.0.0"

app = App()

demo = app.make()

demo.queue().launch(

favicon_path=app._favicon,

inbrowser=[ "libs/ktem/ktem/assets", GRADI_TEMP_DIR, ],

server_name="0.0.0.0",

)

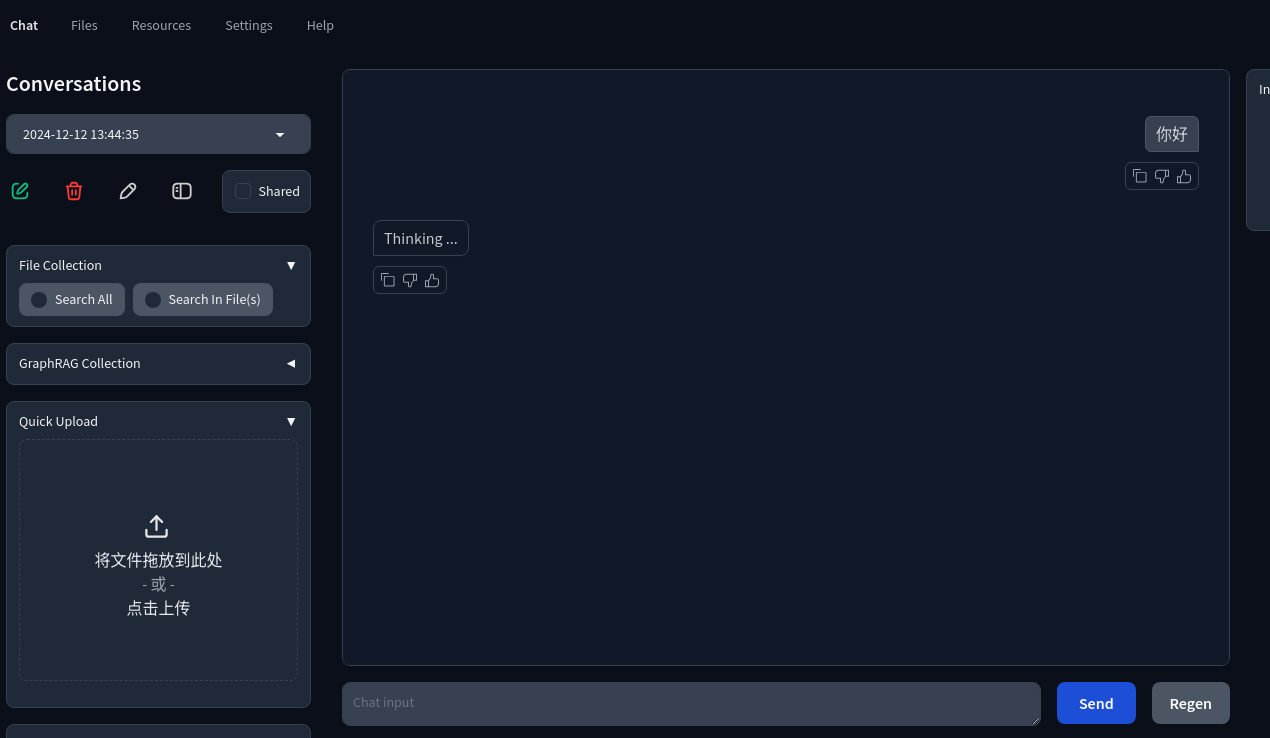

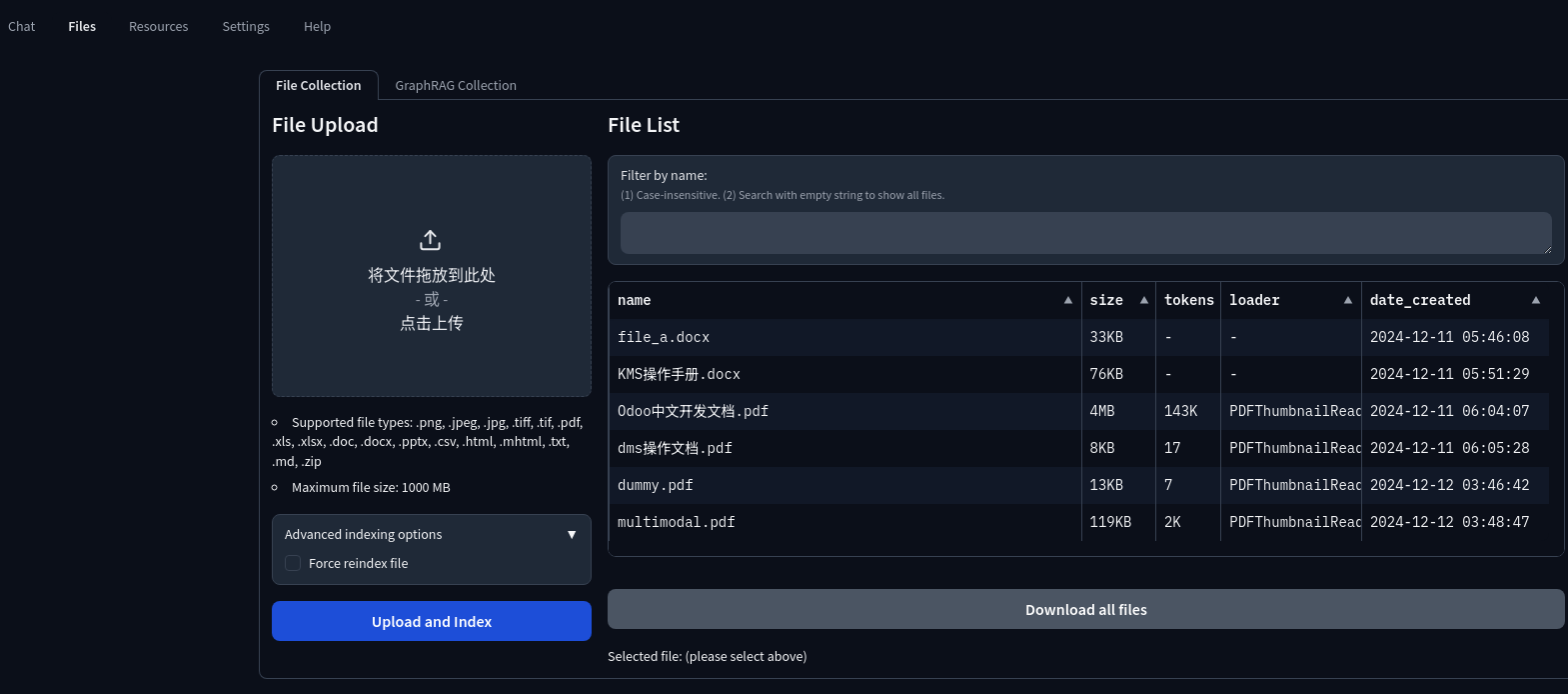

2. 上传文档

在网站首页的右下方可以直接拖拽或点击上传文档,又或者是在Files菜单下上传文档

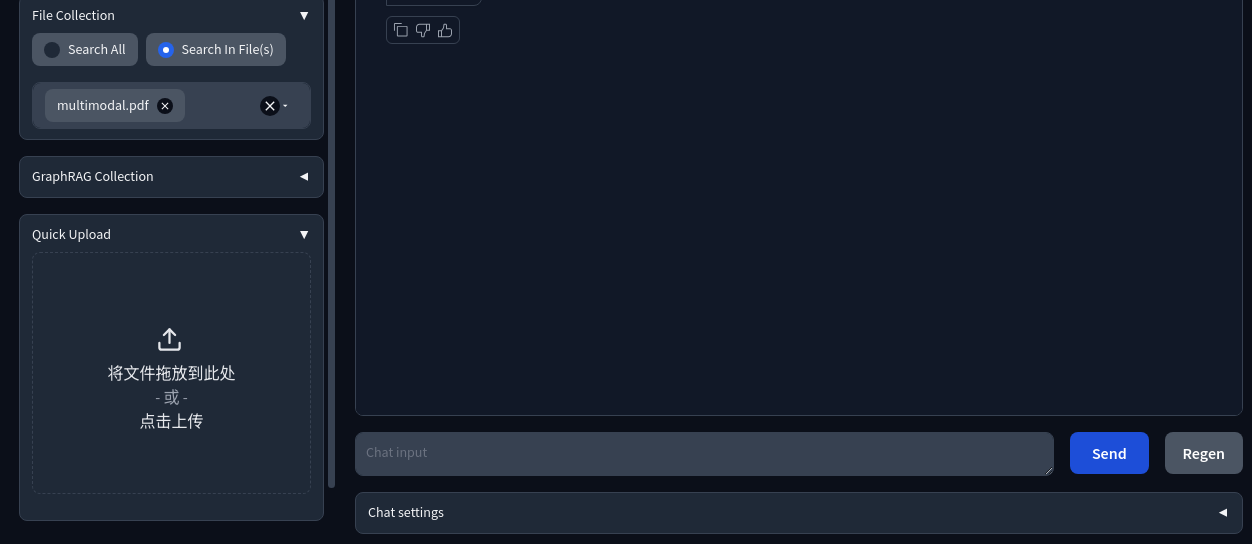

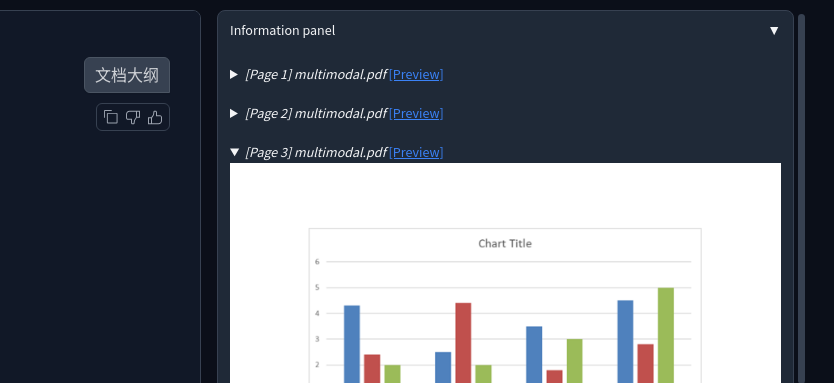

如果需要使用上传之后的文档,可以在File collection中选择需要的文档,选择之后,右侧会显示文档经过Embedding模型处理后得到的信息。

Koataemon操作手册